導入:なぜ今、AIの統一ルールが必要なのか?

近年、対話型AIをはじめとする生成AIの急速な普及は「AIの民主化」と呼べる状況を生み出し、多くの人々がAIを身近なツールとして活用できるようになりました。これにより、企業では既存のビジネスプロセスへのAI導入に留まらず、ビジネスモデルそのものを再構築する動きが加速しています。しかし、この技術革新は光と影を併せ持ち、偽情報・誤情報の拡散や知的財産権の侵害といった、これまでにない新たな社会的リスクも顕在化させています。このような状況下で、AIがもたらす便益を最大化し、リスクを最小限に抑えるためには、事業者一人ひとりが拠り所とすべき共通の指針が不可欠です。本稿で解説する「AI事業者ガイドライン」は、こうした背景を踏まえ、総務省と経済産業省が連携して策定した、事業者が自主的にリスク対策を講じ、イノベーションの促進と社会的な安全・安心を両立させるための統一的な指針です。

——————————————————————————–

1. ガイドラインが目指す3つの基本方針

このガイドラインを効果的に活用するためには、まずその根底にある基本的な考え方を理解することが重要です。この基本方針は、複雑で日進月歩のAI技術を社会に実装していく上で、どのような思想でルールが設計されているかを示しています。ガイドラインは以下の3つの方針を柱としています。

- 事業者の自主的な取組の支援

- 画一的で厳格なルールによって事業活動を縛るのではなく、事業者が直面するリスクの大きさや性質に応じて、柔軟かつ最適な対策を自ら考え、実行することを後押しします。この「リスクベースアプローチ」により、過度な規制によるイノベーションの阻害を防ぎます。

- 国際的な議論との協調

- AIをめぐるルール作りは世界共通の課題です。本ガイドラインは、G7広島AIプロセスをはじめとする国際的な議論の動向と歩調を合わせ、グローバルな整合性を確保しています。これにより、国境を越えて活動する事業者が円滑に事業を展開できる環境を目指します。

- 読み手にとっての分かりやすさ

- AIに関わる事業者は、その役割によって負うべき責任が異なります。本ガイドラインでは、AIのライフサイクルを「開発者」「提供者」「利用者」という3つの主要な立場に分け、それぞれの主体が何をすべきかを明確に整理しています。これにより、事業者は自社がどの役割に該当し、具体的にどのようなリスクと対策を検討すべきかを、迷うことなく確認できます。

これらの基本方針は、AIのバリューチェーン全体で責任ある行動を促すための土台となっており、次に解説する具体的な役割分担の基礎を形作っています。

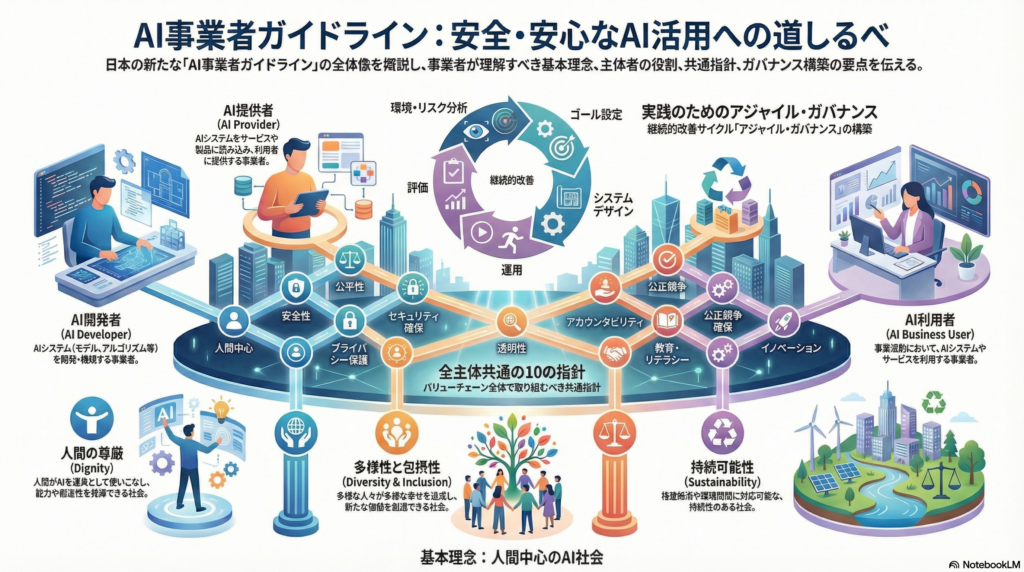

2. AIに関わる3つの立場とそれぞれの役割

AI技術が社会に届くまでには、開発から提供、そして利用に至るまで、様々な事業者が関わる「バリューチェーン」が存在します。ガイドラインを実践する上での第一歩は、自社がこのチェーンの中でどの立場に該当するのかを正確に理解することです。役割と責任範囲を明確にすることで、取るべき対策が具体的になります。ガイドラインでは事業者を以下の3つの主体に大別しており、事業内容によっては同一の事業者がこれらの複数の立場を兼ねる場合もあります。

| 立場 | 主な役割 | 具体的な活動内容の要約 |

| AI開発者 | AIシステムそのものを開発する事業者 | AIモデルの設計、データの収集・学習、AIシステムの構築など、技術的な根幹を担います。 |

| AI提供者 | AIシステムをサービスとして提供する事業者 | 開発されたAIを製品やアプリに組み込み、利用者が使える形にして提供・運用します。 |

| AI利用者 | 事業活動でAIサービスを利用する事業者 | 提供されたAIサービスを、業務効率化等の目的で事業活動に活用します。その際、顧客や社会への影響も考慮し、意図された範囲で適切に利用・運用する責任を担います。 |

これらの3つの立場は独立しているわけではなく、安全で信頼できるAI活用を実現するためには、互いに緊密に連携することが不可欠です。そして、その連携の核となるのが、次に示すバリューチェーン全体で共有すべき「共通の指針」です。

3. 全ての事業者が守るべき「共通の指針」の核心

AIをビジネスで活用する全ての事業者は、その立場(開発者・提供者・利用者)に関わらず、遵守すべき共通の行動規範が示されています。これらの指針は、AI活用における社会的な信頼を構築し、潜在的なリスクを効果的に管理するための土台となるものです。特にビジネスパーソンが理解しておくべき5つの核心的な指針を以下に解説します。

- 人間中心 (Human-Centric)

- 目的 (Why): 人間の尊厳や自律性を最優先とし、AIが人々を不当に操作したり、意思決定の選択肢を狭めたりすることがないようにするためです。

- 具体的な行動 (What): AIの出力結果を盲信するのではなく、最終的な判断は必ず人間が行うプロセスを業務に組み込みます。また、AIが生成した偽情報・誤情報による社会的な混乱を防ぐための対策を講じます。

- 安全性 (Safety)

- 目的 (Why): AIシステムが、人々の生命、身体、財産といったものに危害を加えることがないようにするためです。

- 具体的な行動 (What): 開発・提供・利用するAIが意図通りに動作するかを十分に検証します。また、万が一、予期せぬ事態が発生した場合に備え、対処法をあらかじめ整理し、関係者間で共有しておきます。

- 公平性 (Fairness)

- 目的 (Why): AIが、人種、性別、年齢、国籍といった背景を理由に、特定の個人や集団に対して不当な差別を行わないようにするためです。

- 具体的な行動 (What): AIの学習に用いるデータや、AIが出力する判断結果に偏り(バイアス)が含まれていないか注意深く点検します。その上で、完全に排除できないバイアスが残る可能性を認識し、それが社会的な観点から許容できる範囲内かを評価する視点も重要です。

- プライバシー保護 (Privacy Protection)

- 目的 (Why): AIの学習や利用の過程で、個人のプライバシーが不当に侵害される事態を防ぐためです。

- 具体的な行動 (What): 個人情報保護法をはじめとする関連法令を厳格に遵守します。業務上不必要な個人情報をAIに入力しない、させないためのルールや技術的な仕組みを整備します。

- 透明性とアカウンタビリティ (Transparency & Accountability)

- 目的 (Why): AIがなぜその判断を下したのかを可能な範囲で説明できるようにし、問題が発生した際に誰がどのような責任を負うのかを明確にするためです。

- 具体的な行動 (What): サービスや業務でAIを利用している事実を、関係者(顧客や従業員など)に明確に伝えます。AIの判断プロセスに関するログを記録・保管し、問題発生時の問い合わせ窓口を設置するなど、責任ある対応体制を構築します。ただし、これは必ずしもアルゴリズムやソースコードの開示を意味するものではなく、企業の営業秘密や知的財産を尊重した上で、合理的な範囲で実施されるべきものです。

これらの指針は、AI活用のあらゆる場面で考慮されるべき普遍的な原則です。これを理解し、自社のビジネスプロセスに組み込むことが、信頼されるAI活用の第一歩となります。

4. まとめ:信頼されるAI活用のために事業者が心掛けること

本ガイドラインが伝える最も重要なメッセージは、これがAIの利用を制限するためのものではなく、むしろ事業者が社会からの信頼を獲得し、持続的に成長していくための「羅針盤」であるということです。AI技術は絶え間なく進化し、それに伴う社会的なリスクや期待も変化し続けます。そのため、本ガイドラインは一度策定されたら終わりという固定的なルールではなく、社会の変化に応じて継続的に更新され続ける「Living Document(生きている文書)」として位置づけられています。

この変化に対応するためには、事業者自身も一度ルールを決めれば終わりではなく、具体的には「環境・リスク分析」「ゴール設定」「システムデザイン」「運用」「評価」という改善サイクルを、外部環境の変化に対応しながら継続的に回していく「アジャイル・ガバナンス」の考え方を取り入れることが極めて重要です。AIという強力なツールを責任をもって活用し、その恩恵を最大化していくために、本ガイドラインを道標として、自社の取り組みを常に見直し、改善していく姿勢が求められています。